Pour entraîner des IA comme ChatGPT ou le nouveau Bing AI, il faut des capacités de calculs faramineuses que seuls les plus grands supercalculateurs de la planète peuvent fournir. Des machines qui ne sont pas à la portée de toutes les entreprises, mais IBM fait savoir qu’il en a un.

Ces dernières semaines, beaucoup d’encre à couler autour de ChatGPT et de l’intégration de telles IA conversationnelles au cœur des moteurs de recherche de Bing (avec Bing AI) et de Google (Bard). Par leur faculté impressionnante à comprendre les questions posées par les humains et à générer des réponses élaborées, elles ont fait faire un bon important à l’informatique et aux interactions homme-machine.

Mais ces IA s’appuient sur des modèles linguistiques massifs qui comprennent des centaines de milliards de paramètres et dont l’apprentissage nécessite de leur faire absorber des zéta-octets de documents. Dit autrement, l’apprentissage de ces IA nécessite des capacités de calculs gigantesques et monopolise donc les supercalculateurs HPC parmi les plus puissants de la planète. Ainsi OpenAI (pour le modèle GPT 3 sur lequel se base ChatGPT) s’est appuyé sur un HPC créé par Microsoft dans Azure qui figure parmi les 15 HPC les plus puissants au monde.

Bloom, le modèle linguistique français du projet BigScience initié par la startup Hugging Face et soutenu par le CNRS, a occupé le supercalculateur Jean Zay pendant plusieurs mois.

On le sait la nouvelle entreprise IBM (allégée de la division devenue Kyndryl) s’est bâtie sur le cloud hybride et l’IA même si l’entreprise a beaucoup plus parler de cloud hybride que d’IA ces derniers mois. Mais alors que tout le monde n’a d’yeux que pour les progrès récemment réalisés avec ChatGPT et consorts, IBM veut se rappeler au bon souvenir de tout le monde et lève le voile sur VELA, sont propre et premier supercalculateur spécialement optimisé pour l’entraînement de larges modèles IA. Exclusivement utilisé par IBM Research, il aurait été allumé en mai 2022 et serait depuis l’outil de prédilection de tous ses chercheurs en IA.

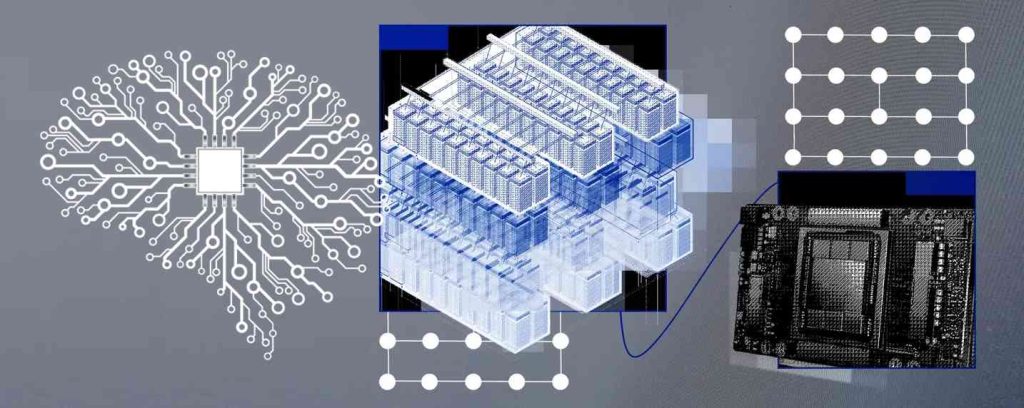

La machine – qui est hébergée et intégrée dans le cloud IBM – est animée par 360 nœuds dotés chacun de deux processeurs Xeon « Cascade Lake » et 8 GPU NVidia A100, de 1,5 To de RAM et de 4 SSD NVMe de 3,2 To chacun. L’ensemble de l’architecture a été optimisée pour un accès depuis un cloud mais aussi pour une utilisation par des VM plutôt qu’en Bare Metal (comme souvent pratiqué en IA). Apparemment, les ingénieurs d’IBM ont adapté l’hyperviseur sous-jacent pour permettre aux VM d’exploiter pleinement les capacités des Nodes (en matière de mémoire et de GPU notamment). La surcharge de la virtualisation aurait ainsi un impact de performance de moins de 5% tout en offrant une flexibilité que le Bare Metal ne permet pas.

On notera au passage qu’IBM a préféré opter pour une architecture Intel Xeon au détriment de ses propres Power 10.

Dans son papier de présentation, IBM explique que « ce travail a été effectué dans l’optique de fournir des performances et une flexibilité pour les charges de travail d’IA à grande échelle, mais l’infrastructure a été conçue pour pouvoir être déployée dans n’importe lequel de nos centres de données mondiaux, à n’importe quelle échelle. Et bien que ce travail ait été réalisé dans le contexte de notre cloud public, l’architecture pourrait également être adoptée pour la conception de systèmes d’IA sur site. »

Dit autrement, IBM semble vouloir à terme offrir l’accès à Vela à des équipes externes à IBM et même à déployer des machines similaires dans d’autres datacenters dans le monde.

À lire également :

Microsoft dévoile le nouveau Bing dopé à l’IA… Et ça change tout !

Microsoft ChatGPT vs Google Bard, la guerre des IA est lancée

IBM va licencier 3900 personnes dans le monde

IBM accuse Micro Focus de violation de copyright sur les mainframes

puis

puis