Des cybercriminels qui se cachent derrière la voix de votre PDG. Barak Obama qui tient un discours invraisemblable. Une vidéo virale sur les réseaux sociaux qui paraît vraie mais est totalement fictive. Utilisés à des fins politiques, partisanes ou cybercriminelles, les contenus trafiqués à l’IA envahissent le quotidien… Savez-vous les reconnaître ?

L’Intelligence Artificielle est comme un couteau : elle peut être très utile au quotidien et simplifier la vie et le travail de chacun mais elle peut aussi servir d’arme et constituer une menace. L’usage détermine la fonction…

Les récents progrès en matière de Deep Learning permettent désormais à des ordinateurs de recréer des lieux, des personnes, des visages, des voix, des objets totalement fictifs mais dont le réalisme est tel que nos sens humains sont incapables de percevoir qu’ils sont faux.

Aujourd’hui, des apps comme Zao permettent de placer son propre visage en lieu et place d’un acteur sur n’importe quelle scène cinématographique avec un réalisme bluffant.

L’humoriste Jordan Peele a démontré l’an dernier un autre usage spectaculaire : les télespectateurs voyaient et entendaient sur leur écran le visage et la voix de Barak Obama, mais c’était en réalité le comique américain qui parlait en temps réel et faisait dire n’importe quoi à un Barak Obama totalement virtualisé.

En mars 2019, des cybercriminels ont utilisé une IA pour imiter la voix du PDG d’une entreprise anglaise et inciter son directeur financier joint par téléphone à réaliser un virement en urgence. Ils ont ainsi réussi à dérober 200 000 euros. La requête avait bien interpelé le responsable mais la voix et les intonations étaient si réelles qu’il n’avait pas imaginé un seul instant avoir quelqu’un d’autre que son PDG au bout du fil.

Depuis plus d’un an, les « deepfakes », ces contenus fictifs trafiqués ou générés grâce à l’IA, envahissent les réseaux sociaux. Comme le rappelait Brad Smith, président de Microsoft dans un billet de blog sur les « 10 grands défis humains soulevés par les technologies dans les 10 ans à venir », les deepfakes ne sont pas qu’une menace pour la sécurité des entreprises et des internautes, ils sont aussi et surtout une menace pour nos démocraties et les processus électoraux notamment au travers de campagnes de désinformation qui se répandent de façon virale sur les réseaux sociaux.

Et pour contrer ces « IA du faux », il faudra parfois s’appuyer sur d’autres IA à même de démasquer les supercheries que nos sens humains ne peuvent percevoir.

Microsoft Research a dévoilé hier une nouvelle technologie co-développée avec le « Defending Democracy Program » et la BBC (Project Origin). Microsoft Video Authenticator peut analyser une photo ou une vidéo puis fournir un pourcentage de chance, ou « score de confiance », que le média ait été artificiellement manipulé. Dans le cas d’une vidéo, il peut fournir ce pourcentage en temps réel sur chaque image lorsque la vidéo est lue.

Video Authenticator n’a pas pour l’instant vocation à devenir un outil accessible à tous. Son utilisation est limitée d’une part au Project Origin de la BBC en collaboration avec CBC/Radio-Canada et le New York Times, et d’autre part à un partenariat avec l’association RD2020 (Reality Defender 2020). Cette dernière rendra la technologie de Microsoft Research disponible aux organisations engagées dans les processus démocratiques à commencer par les journalistes. L’association dispose d’ailleurs d’autres outils expérimentaux de lutte contre les deepfakes, eux aussi à diffusion restreinte.

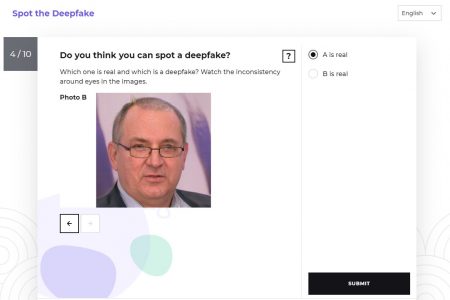

Mais Microsoft a également lancé hier un outil (pour l’instant uniquement en anglais) pour sensibiliser les internautes au problème du DeepFake. Ce quizz éducatif permet à tout un chacun de tester sa sagacité et de vérifier sa capacité à repérer un DeepFake d’un contenu authentique. Dénommé « Spot The Deepfake », ce test didactique et amusant veut éduquer les internautes sur les indices qui peuvent aider à repérer des photos et vidéos trafiquées mais aussi rappeler à quel point certains trucages sont difficiles à démasquer.

À l’heure où la campagne pour l’élection électorale aux USA bat son plein, la lutte contre les DeepFakes s’intensifie. Des chercheurs du MIT viennent également de publier un papier sur Arxiv autour d’un algorithme permettant de repérer les images trafiquées.

Par ailleurs, il existe des extensions pour navigateurs Web qui tentent d’alerter les internautes lorsqu’elles repèrent des fake news ou des fake médias. Les plus connues sont SurfSafe et B.S. Detector, mais ces deux projets sont aujourd’hui à l’abandon. Microsoft propose également NewsGuard disponible sur Chrome et sur Edge (y compris sous iOS et Android).

Enfin rappelons que l’IA n’est pas la seule technologie qui peut nous permettre de lutter contre les DeepFakes. D’autres innovations comme la Blockchain ont également leur rôle à jouer pour authentifier les sources d’information notamment.

Reste que tous ces projets sont encore assez immatures alors que les progrès en IA et notamment en DeepFakes progressent eux à grande vitesse. En attendant de disposer d’outils techniques fiables, les utilisateurs vont devoir faire preuve de sens critique et d’intelligence pour sans cesse repérer le bon grain de l’ivraie.

puis

puis